- เปิดโลก iot ด้วย NodeMCU, มือใหม่ทำไมต้องลอง?

- มีอะไรในงาน Microsoft Build AI day Thailand 2024

- รีวิวหนังสือ: "Leading Snowflake" โดย โอเรน เอเลนบอเกน

- OWASP TOP 10 สิบช่องโหว่สุดอันตรายที่ developer ทุกคนต้องพึงระวัง!

- เคล็ดลับการออกแบบซอร์ฟแวร์เพื่อความยืดหยุ่น (Resiliency Design)

- ลองใช้ kubernetes บนเครื่อง localhost ด้วย Minikube

- เตรียมสอบ AZ-104 Microsoft Azure Adminstrator certificate

- คอนเซปในการทำงานของ Kubernetes

- วิเคราะห์ NodeJs source code ด้วย SonarQube

- ทำความรู้จักกับ Nexus repository manager

มีอะไรในงาน Microsoft Build AI day Thailand 2024

EventMay 5th, 2024

ผมได้มีโอกาสร่วมงาน Microsoft build AI day Thailand ที่จัดขึ้นที่ศูนย์ประชุมแห่งชาติสิริกิติ์เมื่อวันที่ 1 พฤษภาคม 2024 ที่ผ่านมา งานนี้ CEO ของ Microsoft คุณสัตยา นาเดลล่า (Satya Nadella) ได้มาเปิดงานและแสดงวิสัยทัศน์ของ Microsoft เกี่ยวกับปัญญาประดิษฐ์ที่จะขยายในเอเชีย โดยมีนายกรัฐมนตรีคุณเศรษฐา ทวีสิน มากล่าวสุนทรพจน์ด้วย ใจความหลักๆคือรัฐบาลมองเห็นความสำคัญในการร่วมมือพัฒนาประเทศด้วย AI ไปกับบริษัท Microsoft และจะสนับสนุนการเติบโตทางด้านนี้อย่างเต็มที่

🎉 หัวข้อที่ดูจะเรียกเสียงฮือฮาได้มากที่สุดก็คือการที่ Microsoft ประกาศว่าจะมาลงทุนและจัดตั้ง data center ในประเทศไทย ซึ่งเรียกเสียงปรบมือจากผู้ชมได้เกรียวกราวเลยทีเดียวครับ

โดยในงานนี้ Microsoft ก็ได้เชิญลูกค้าชั้นนำ อย่างเช่น SCBX และ Agoda เข้ามาร่วมแชร์ประสบการณ์ของการนำ AI เข้ามาใช้ในองค์กรด้วย

ไฮไลท์สำคัญๆของงานที่ผมเลือกมาแชร์จะมีประมาณนี้

- Features ของ Copilot และการนำมาประยุกต์ใช้กับองค์กร

- สาธิตการใช้งาน Azure AI studio

- Features ใหม่ๆใน generative AI

- โปรโมท Microsoft Asia AI Odyssey แคมเปญการเรียนรู้เพื่อช่วยพัฒนาทักษะทางด้าน AI

- SCBX แชร์ case การประยุกต์ใช้ AI ในการช่วยมอนิเตอร์และจัดการชื่อเสียงในโลกออนไลน์ (online reputation management)

- Agoda แชร์ประสบการณ์ในการนำ AI เข้ามาใช้ในองค์กร

- ข้อมูลทางด้านเทคนิค

- สาธิตวิธีการใช้ vector search

- การใช้ RAG application และ prompt flow

- ให้ความรู้เกี่ยวกับ LLMOPs

หมายเหตุ บทความนี้เป็นการบันทึกประสบการณ์จากมุมมองของผมซึ่งเป็นหนึ่งในผู้เข้าร่วมงาน อาจมีข้อมูลบางส่วนที่ตกหล่นหรือไม่ถูกต้องสมบูรณ์ ผู้อ่านควรใช้วิจารณญาณในการอ่านและทำความเข้าใจนะครับ

การใช้งาน Microsoft Copilot

Microsoft นำเสนอการใช้งาน Copilot ออกมาเป็น 3 ประเภทหลักๆก็คือ

- การประยุกต์ใช้ (adopt): การใช้ประเภทนี้ก็คือตัว Copilot เองฝังอยู่ใน application ที่เราใช้งานอยู่แล้วอย่างเช่น Microsoft 360, Power BI, Excel เป็นต้น ในส่วนนี้จะเป็นในรูปแบบของ Plug ins ตัวอย่างเช่นใน excel คุณสามารถพิมพ์บอก Copilot ให้จัดเรียงรูปแบบของตารางใหม่โดยไม่ต้องใส่สูตรหรือว่าเขียนสคริปเอง

- พัฒนา application ด้วย low code (extend): ในส่วนนี้จะเป็นการใช้งานของ Copilot เพื่อช่วยเขียนโค้ดให้กับเราผ่านปลั๊กอินใน virtual studio code หรือการช่วยแก้บั๊กโดยให้ Copilot อ่าน GitHub issue และทำการสร้าง pull request เพื่อมาแก้ไขได้เลย

- การปรับแต่ง Copilot ให้เหมาะกับการใช้งาน (custom): ในส่วนนี้ก็เป็นการใช้งานที่ซับซ้อนขึ้นไปอีกหน่อย โดยผู้ใช้สามารถสร้างโมเดลขึ้นมาเองเพื่อที่จะปรับแต่ง Copilot ด้วยข้อมูลที่จะพอเจาะจงสำหรับองค์กร ผ่าน Azure AI service และ Azure AI studio

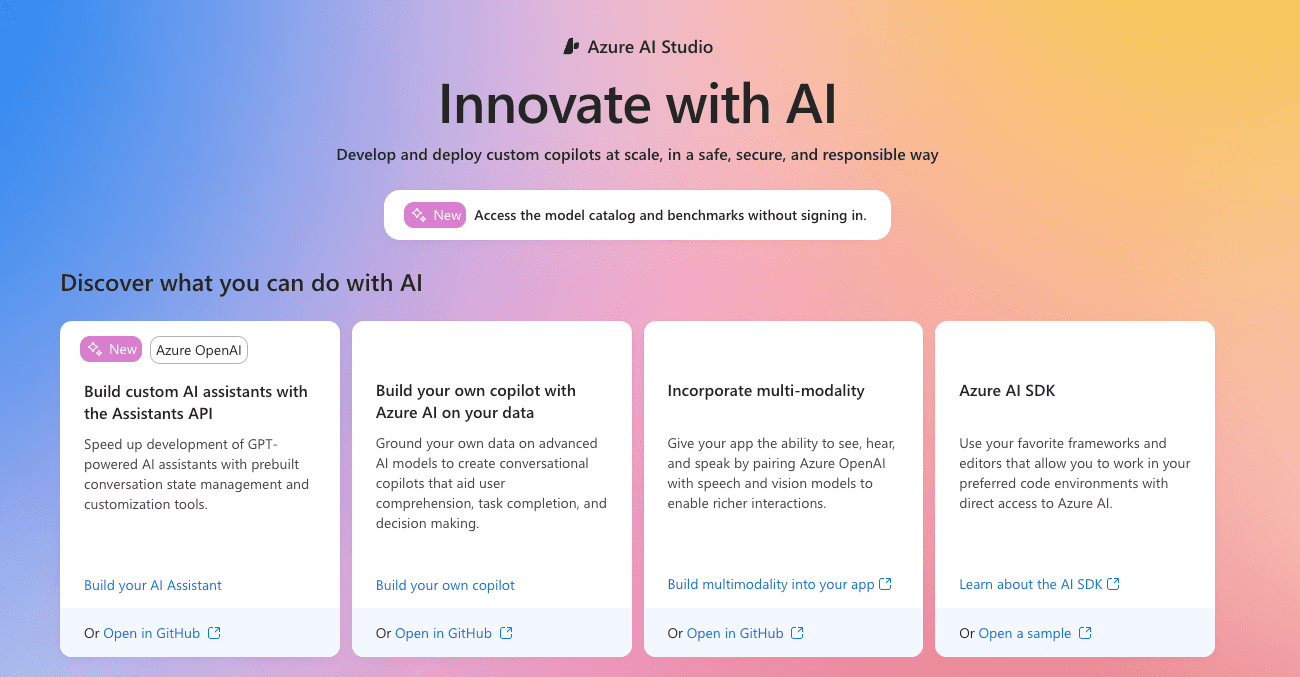

การใช้งาน Azure AI studio

Azure AI Studio เป็นอีกหนึ่ง platform ใน Microsoft Azure Cloud ที่ช่วยนักพัฒนาสร้าง AI ที่เหมาะสมกับองค์กรของตัวเอง ซึ่งเครื่องมือนี้รองรับการทำงานแบบ low code โดยที่ผู้ใช้งานไม่จำเป็นจะต้องมีความรู้ด้านโปรแกรมิ่งเลย แต่ต้องเข้าใจว่า AI ทำงานยังไงแค่นี้ก็สามารถสร้าง AI ให้เหมาะกับองค์กรของตัวเองได้

โดยในงาน Microsoft ได้มีการสาธิตการใช้งานเจ้าตัว studio นี้จากหลายๆ use cases ที่แตกต่างกัน ตัวอย่างเช่นการใช้ AI ในการเลียนเสียงผู้พูดและแปลเป็นภาษาอื่น เป็นการสร้าง support chatbot ด้วยข้อมูลที่เฉพาะเจาะจงขององค์กร

มีอะไรใหม่ใน Generative AI

ในหัวข้อนี้ก็ไม่มีอะไรมากครับส่วนใหญ่จะเป็นการโชว์เคสซะมากกว่า ซึ่งในปัจจุบันทุกคนคงทราบดีอยู่แล้วว่านอกจากการรับ input เป็น text แล้วเจ้าตัว generative AI ยังสามารถรับข้อมูลเป็น รูปภาพ เสียง หรือว่าวีดีโอได้ มีการ demo โดยการใส่เสียงเป็นภาษาไทยเข้าไปและให้เจ้าตัว AI จดจำเสียงนั้นๆและทำการพูดโต้ตอบเป็นภาษาอื่นๆได้ นอกจากนี้ยังมีการนำ Avatar มาเรียนเสียงและเคลื่อนไหวเสมือนเป็นคนจริงๆอีกด้วย

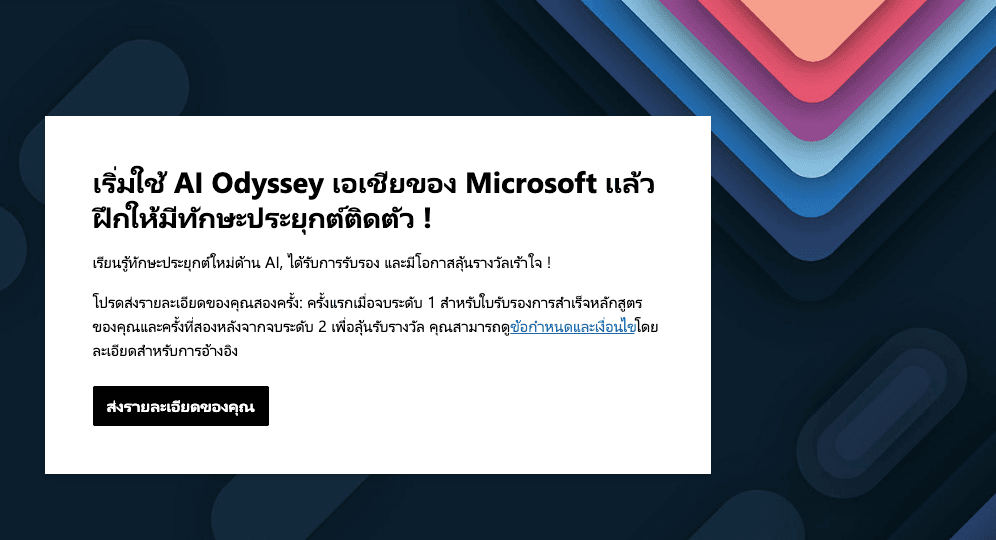

พัฒนาทักษะด้าน AI กับ Microsoft AI Odyssey แคมเปญ

Microsoft AI Odyssey เป็นโครงการที่ออกแบบมาเพื่อผู้พัฒนาที่ต้องการยกระดับความสามารถด้าน AI ของตนเอง โดยจะมีลิมิตเวลาตั้งแต่วันที่ 8 กุมภาพันธ์ ถึง 25 มิถุนายน 2024 ผู้ที่เข้าร่วมจะได้เรียนรู้และทดสอบทักษะใหม่ๆ ด้าน AI ผ่านการเรียนรู้จาก Microsoft learn, ทำแบบฝึกหัดและการประเมินผลที่เกี่ยวข้องกับ Azure AI services โดยการเรียนจะแบ่งเป็น 2 ระดับดังนี้

- ระดับที่ 1: ผู้เข้าร่วมจะต้องเข้าเรียน AI กับ Microsoft Learn ซึ่งเป็นการประยุกต์ใช้ Microsoft AI services ในสถานการณ์ต่างๆให้ครบตามจำนวนที่กำหนด หลังจากนั้น Microsoft จะออกใบรับรองการเข้าร่วมโครงการให้

- ระดับที่ 2: จะเป็นการทำแบบทดสอบออนไลน์ เมื่อสอบผ่าน Microsoft จะออกใบ certificate เพื่อรับรองทักษะทางด้าน AI ให้ผู้เข้าร่วมโครงการ

ใครสนใจสามารถลงทะเบียนและเริ่มเรียนได้เลยตามลิงค์นี้ครับ Microsoft AI Odyssey

แบ่งปันประสบการณ์จาก SCBX - การบริหารความเสี่ยงทางชื่อเสียงด้วย AI

ในช่วงต้น ดร.อารักษ์ สุธีวงศ์ ประธานเจ้าหน้าที่บริหารของ SCBX ได้มาแชร์วิสัยทัศน์และความสำเร็จในการใช้ AI ในองค์กร ซึ่ง SCBX ได้วางตัวเองเป็น AI first organization ซึ่งถือว่าเป็นภาระกิจที่ท้าทายมาก

หลังจากนั้นได้มีทีมงานของทาง SCBX มาแชร์เคส เกี่ยวกับการบริหารชื่อเสียงทางออนไลน์ของบริษัท (Reputation incident management)

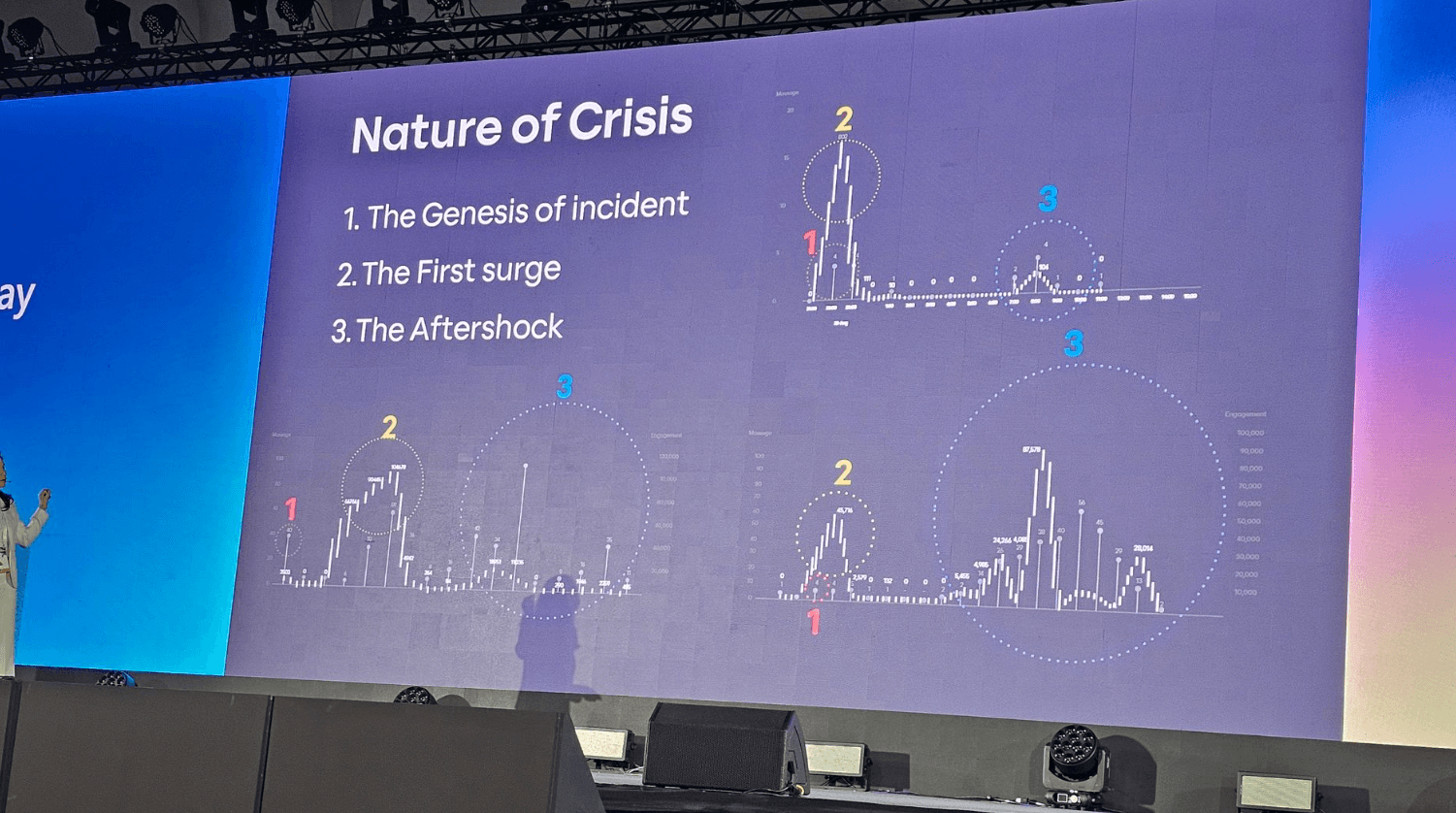

ซึ่งทาง SCBX ได้พบว่าวิกฤตที่จะส่งผลกระทบกับชื่อเสียงของบริษัทหรือองค์กรจะแบ่งได้เป็น 3 เฟส

- The genesis of the incident: ซึ่งก็คือจุดเริ่มต้นของเหตุการณ์อาจจะเป็นรีวิวลบๆหรือว่าการ complain ใน social media ซึ่งจุดนี้เหตุการณ์อาจจะดูเล็กน้อย แต่สามารถส่งผลที่ใหญ่หลวงได้ในเฟสถัดๆไป

- The first surge: ในเฟสนี้จะเป็นช่วงการแพร่กระจายของความคิดซึ่งอาจจะเกิดจากการนำข้อมูลไปแชร์ต่อๆกันอย่างผิดๆ ในสาธารณะซึ่งในเฟซนี้เหตุการณ์จะเกิดขึ้นได้รวดเร็วมากและส่งผลถึงความเสียหายทางชื่อเสียงอย่างใหญ่หลวง

- The Aftershock: ในเฟสนี้จะเป็นผลพวงจากเฟสที่แล้วซึ่งในเฟสนี้จะกินระยะเวลายาวนาน และส่งผลกระทบทางชื่อเสียงอย่างถาวร

ซึ่งทาง SCBX ก็ได้เล่าว่าก่อนหน้าที่จะนำเทคโนโลยี AI มาใช้ จะเป็นการใช้ระบบผสมกับมนุษย์ในการ detect ปัญหาและส่ง alert เพื่อหาทางแก้ไข อย่างไรก็ตามวิธีนี้กว่ากระบวนการจะเสร็จสมบูรณ์ ก็จะไปอยู่ในช่วงท้ายของ incident แล้ว ซึ่งมีความ passive ทำให้ไม่สามารถกอบกู้ชื่อเสียงหรือแก้ปัญหาได้ทันเวลา

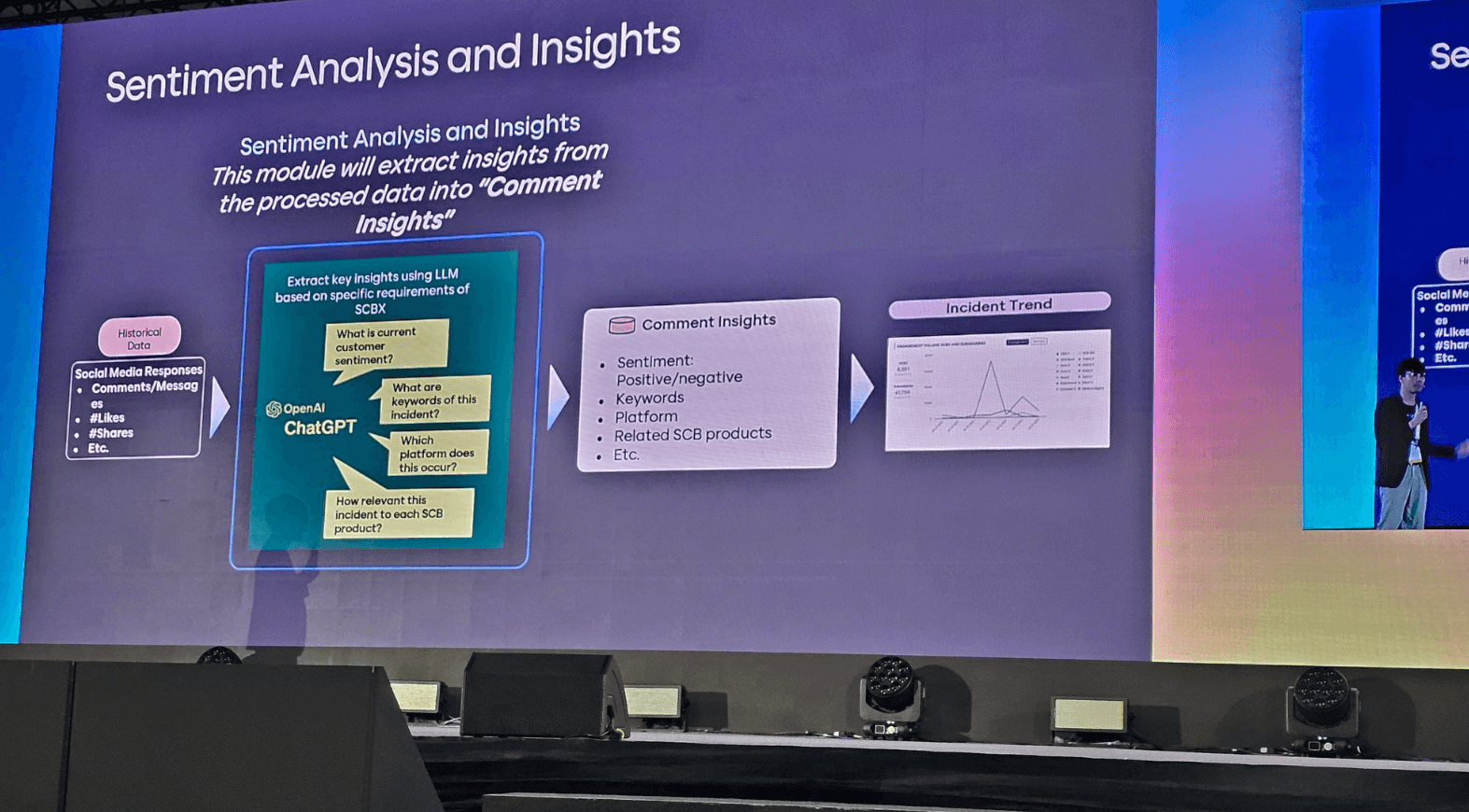

ด้วย workflow ใหม่ SCBX ได้นำ ChatGPT เข้ามาช่วย process ข้อมูลที่ได้รับมาจาก social media feed และทำการวิเคราะห์เพื่อที่จะส่งการแจ้งเตือนถึง incident รวมทั้งสรุปข้อมูลต่างๆเพื่อเก็บไว้ใน dashboard ของบริษัท ซึ่งจะทำให้การเฝ้าระวังและวางแผนการจัดการรับมือกับปัญหาได้รวดเร็วและทันเวลา กระบวนการนี้ช่วยปรับปรุงให้บริษัทมีความ active ในการแก้ไขเมื่อปัญหาเพิ่งเริ่มเกิด ซึ่งรวดเร็วและมีประสิทธิภาพกว่ามากเมื่อเทียบกับวิธีการเดิมอย่างมีนัยยะสำคัญ

การนำ AI เข้ามาใช้ในองค์กรของ Agoda

ทางส่วนของ Agoda จะได้มีการแชร์ประสบการณ์ในการนำ AI เข้ามาใช้ในองค์กร โดยเริ่มแรก จะเป็นการนำ AI เข้ามาช่วยในการเพิ่ม productivity ภายในก่อน โดยมีการจัด AI hackton ในองค์กรเมื่อเดือนกุมภาพันธ์ปี 2024 ที่ผ่านมานี้เอง ซึ่ง Agoda มีการสร้าง AI community channel ภายในองค์กรเองเพื่อให้พนักงานได้แลกเปลี่ยนข้อมูลและความรู้กัน โดย Agoda อนุญาตให้พนักงานทุกคนเข้าถึงเครื่องมือทาง AI ได้

หลังจากนั้นก็ได้มีการนำ Copilot และ Open AI proxy เข้ามาพัฒนา product และเครื่องมือเพื่อใช้กับองค์กรและลูกค้า

Agoda เคลมว่าณปัจจุบันมี services ที่ใช้ OpenAI ในองค์กรอยู่ประมาณ 110 services ตัวอย่างเครื่องมือที่ใช้ภายในเช่น

- เครื่องมือช่วยสร้าง component UI

- Playground ที่ช่วยร่างไอเดีย

- Query assistant เพื่อช่วยในการสร้าง SQL

- Document processor ที่ช่วยในงานเอกสารอย่างเช่น การสรุปและสร้างไฟล์ CSV

รวมถึงยังมีเครื่องมือที่ใช้ AI เพื่อ support ลูกค้าเช่น

- Askoda ซึ่งเป็นแชทบอทที่ช่วยตอบคำถามลูกค้า

- Semantic search ช่วยให้ประสิทธิภาพการค้นหาความแม่นยำขึ้น

- AI review ช่วย user ในการเขียนรีวิว

- Property ask me anything ไปช่วยตอบคำถามเกี่ยวกับที่พัก

การแชร์ความรู้ทางด้านเทคนิคเกี่ยวกับ AI

ภายในงานจะมีการแชร์เทคนิคเกี่ยวกับ AI เป็นระยะๆ คีย์เวิร์ดทางด้านเทคนิคที่ผมพอจะจับใจความได้ก็มีดังนี้ครับ

MLOPs (Machine Learning Operation) และ LLMOPs(Large Language Model Operations)

Machine Learning (ML)

ML หรือ machine learning เป็นกระบวนการดั้งเดิมที่ใช้ฝึก AI ซึ่งกระบวนการเหล่านี้จะเฉพาะเจาะจงไปที่เคสใดเคสหนึ่ง คนที่จะมาทำการพัฒนา machine learning จะเป็น machine learning engineer และ data scientist หลักการสร้างโมเดลของ machine learning นี้จะเริ่มด้วยข้อมูลจากศูนย์และใช้ database ใหญ่ในการสอน AI

ตัวอย่างเช่นการหาคำตอบของอาหารเย็นที่เป็นอาหารไทยและมีคาร์โบไฮเดรตน้อย การจะหาคำตอบอย่างนี้ใน machine learning เราจะต้องมีโมเดลที่สร้างมาเพื่อการหาคำตอบแบบนี้โดยเฉพาะและสอนโมเดลด้วย database ที่มีข้อมูลของอาหารที่รวมไปถึงประเทศที่ผลิตอาหารและจำนวนแคลอรี่ที่ได้จากอาหารนั้นๆ หรือเรียกอีกอย่างหนึ่งว่าการ labelling นั่นเอง คำตอบที่ได้ออกมาจะเป็นลิสต์ของอาหารโดยไม่มีการใส่ภาษามนุษย์ในการตอบรับเข้าไป คล้ายๆกับการ lookup database ใหญ่ที่มีข้อมูลเฉพาะเจาะจงของสิ่งที่เราต้องการหา

Large Language Model (LLM)

ส่วน LLM หรือว่า Large Language Model จะมีความ generic มากกว่า ผู้ที่จะพัฒนา LLM นี้จะเป็น machine learning engineer และ application developer ตัวอย่างของ LLM ที่เราใช้กันอยู่ทุกวันนี้ก็คือ ChatGPT นี้เองครับ

ตัวอย่างการ process ข้อมูลของ LLM เมื่อเราถามว่า “เย็นนี้ฉันจะกินอะไรดี ที่เป็นอาหารไทยและให้พลังงานน้อย”

- เริ่มแรกระบบจะทำการจำแนกความหมายของ input ที่ใส่เข้าไปในที่นี้ก็คือ “อาหารไทย” และ “พลังงานน้อย”

- พอได้คีย์เวิร์ดมาแล้ว ระบบก็จะทำการค้นหาค่าใน database ที่เกี่ยวข้อง ซึ่งในกรณีนี้ก็จะมี database ของ ส่วนประกอบอาหารต่างๆ, list ของอาหารไทย, และคุณค่าทางโภชนาการของส่วนผสมที่อยู่ในอาหารซึ่งจะเป็น database ที่อยู่แยกออกจากกัน

- หลังจากได้ข้อมูลมาจากหลายๆทางแล้วระบบก็จะทำการ filter สิ่งที่ไม่เกี่ยวข้องออกไป ตัวอย่างเช่นหลังจาก filter แล้วอาจจะได้ลิสต์ของอาหาร เป็น ข้าวต้มกุ้ง, ข้าวผัดปู, ข้าวขาหมู

- หลังจากได้ลิสต์ของคำตอบแล้วระบบก็จะทำการใส่ภาษามนุษย์ลงไปเพื่อตอบโต้กับผู้ใช้งานตัวอย่างเช่น “ข้าวต้มกุ้งเป็นหนึ่งในเมนูอาหารไทยที่น่าสนใจ หากคุณต้องการอาหารที่มีแคลอรี่ต่ำและดีต่อสุขภาพ…”

การหาข้อมูลด้วย Vector search

กระบวนการนี้น่าสนใจครับ แทนที่จะใช้ข้อความในการค้นหาอย่างเดียวกระบวนการเวกเตอร์ search เป็นการแบ่ง dimension ย่อยๆของสิ่งต่างๆและสุดท้ายนำ dimension เหล่านั้นมาทำการ Cosine เข้าด้วยกันทำให้ได้รับคำตอบที่แม่นยำมากที่สุด ยกตัวอย่างสัตว์ 3 คำนี้ และตัวอย่าง dimension ของความยาวจมูกและความเร็ว

- สุนัข (0.8,0.6)

- แมว (0.5,0.9)

- ไซบีเรียนฮัสกี้ (0.9,0.7)

เมื่อนำมา Cosine กัน

- สุนัข กับ ไซบีเรียนฮัสกี้ = 1

- สุนัข กับ แมว = 0.94

ดังนั้นไซบีเรียนฮัสกี้จึงเป็นคำตอบที่ใกล้เคียงกับสุนัขมากกว่าแมวครับ ซึ่งในตัวอย่างมีแค่ 2 dimensions แต่ในสถานการณ์จริงๆ สุนัขแมวและไซบีเรียนฮัสกี้ จะมี dimension ให้เทียบกันมากกว่านี้มหาศาล เทคนิคการใช้ vector search จึงเป็นกระบวนการการค้นหาที่มีประโยชน์และให้ความแม่นยำมากขึ้น

การใช้ Retrieval-Augmented Generation (RAG) และ prompt flow

ตลอดงานบรรยาย AI ใน event นี้เราจะได้ยินคีย์เวิร์ดคำว่า RAG บ่อยมาก ซึ่งกระบวนการนี้ถือเป็นหัวใจสำคัญใน LLM ซึ่งเป็นการทำให้คำตอบมีความแม่นยำขึ้น เรียกว่าการ grounding ซึ่งจะนำผลลัพธ์ที่ได้ในตอนแรก ไปค้นหาด้วยข้อมูลจาก database ข้างนอกที่มีความเป็นปัจจุบันมากกว่าเพื่อที่จะเพิ่มคอนแทคเกี่ยวกับสิ่งที่ค้นหานั้น ยกตัวอย่างเช่นถ้ามี keyword ในการค้นหาเกี่ยวกับคำว่า capital ซึ่งคีย์เวิร์ดตัวนี้จะแปลว่า เมืองหลวง เงินสด หรือว่าตัวอักษรก็ได้ กระบวนการ RAG จะช่วยเพิ่ม context เพื่อช่วย scope การหาคำตอบให้มีความแม่นยำขึ้น

ส่วน Prompt Flow เป็นกระบวนการสร้างและทดสอบ prompt หลายๆอันที่อยู่ในการหาคำตอบของระบบ ซึ่งหนึ่งในกระบวนการที่ RAG ใช้ก็คือการใช้ prompt หลายๆอันมาช่วยหาคำตอบนั่นเอง

สรุป

การได้เข้าร่วมงาน Microsoft Build AI day Thailand 2024 สำหรับผมแล้วถือว่าคุ้มค่ามากๆครับ แม้ว่าจะต้องเสียสละวันหยุดแรงงานไปก็ตาม (ฮ่าๆ) ถือว่าเป็นครั้งหนึ่งในชีวิตที่ได้ไปเห็น CEO ของบริษัท Microsoft ตัวเป็นๆ ซึ่งเป็นโอกาสที่มีไม่บ่อยนัก

การได้เห็นวิสัยทัศน์และแนวคิดขององค์กรอื่นในเมืองไทยที่มีต่อเทคโนโลยี AI ก็ช่วยสร้างแรงบันดาลใจในการศึกษาเทคโนโลยีเหล่านี้ไม่น้อยเลย นอกจากนี้ผมยังได้ keyword ทางด้านเทคนิคมากมายเพื่อนำไปต่อยอดในการหาความรู้ทางด้าน AI ของตัวเองเพิ่มขึ้น

สุดท้ายนี้ขอปิดท้ายด้วยคำคมที่ผมได้จากงานนี้ครับ

🔪 “AI ไม่ได้จะมาแทนมนุษย์ แต่มนุษย์ที่รู้ AI จะมาแทนมนุษย์ที่ไม่รู้ AI”

คมไหมครับ? อย่าลืมลงเรียน AI Odyssey กันนะครับ

สอบถาม ติชม เสนอแนะ ได้ที่ช่อง comment ด้านล่างเลยครับ